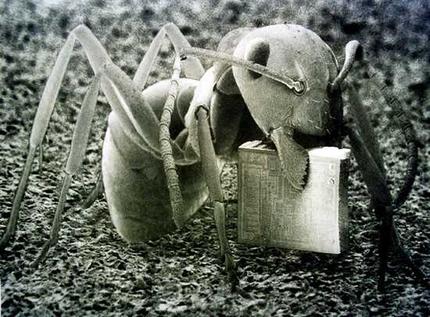

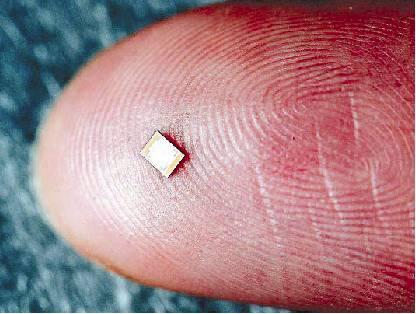

Sem microships não haveria calculadoras, PCs e notebooks. Os chips wafer, também chamados de circuitos integrados, armazenam um infinito de informação. Os microchips são feitos de silicone e sua produção exige muito tempo. Para criar os atuais condutores, técnicas diferentes são utilizadas para sobrepor materiais estranhos como o alumínio ou cobre na superfície de silicone. Cada partícula de poeira conta: afinal ...

Sem microships não haveria calculadoras, PCs e notebooks. Os chips wafer, também chamados de circuitos integrados, armazenam um infinito de informação. Os microchips são feitos de silicone e sua produção exige muito tempo. Para criar os atuais condutores, técnicas diferentes são utilizadas para sobrepor materiais estranhos como o alumínio ou cobre na superfície de silicone. Cada partícula de poeira conta: afinal ...

qualquer tipo de contaminação em um local que reúne quase um bilhão de transistores ao mesmo tempo em apenas um centímetro quadrado, pode ser desastrosa. O pioneiro americano em eletrônica, Jack Kilby que recebeu o Prêmio Nobel em Física devido ao seu trabalho em 2000, é considerado o inventor do microchip. O físico apresentou o microchip ao público nos laboratórios do Texas Instruments em 1958. Cinco transistores soldados em um pedaço de germânio para criar um circuito, o primeiro chip já era do tamanho de um clipe de papel. As estruturas nos microchips se tornaram menores e menores.

Leia também - Celulares: como escolher

Fabricantes de chip passaram a dobrar o número de transistores em um chip a cada 18 meses como previsto pela lei Moore. Entretanto, com a escala do tamanho reduzida para átomos, os fabricantes continuam indo contra os limites da miniaturização. Chegou então a hora de tentar novos métodos de abordagem. Os pesquisadores buscam soluções como “nanotubos de carbono”, que eles esperam poder usar em microchips no futuro. Está em toda parte… e não pode ser visto. Alterou praticamente todos os aspectos de nossas vidas… e muitas pessoas nem sabem que ele existe. Revolucionou as comunicações, a multimídia, o entretenimento, a educação, a medicina, o transporte, a ecologia… e é quase invisível. Possibilitou empreitadas fantásticas, como a exploração espacial, e invenções incríveis, como a Internet. Estamos, a quase todo momento, cercados por eles… e nem nos damos conta!

Estamos falando de uma pequenina invenção, que hoje tornou-se indispensável para a vida moderna e que vem propelindo a era da informação: o microchip -- ou simplesmente chip.

Esse diminuto dispositivo eletrônico, com menos de cinco décadas, vem possibilitando uma série de inovações sem precedentes na História, podendo, sem dúvida, ser incluído na lista das mais notáveis invenções da humanidade. O microchip e a Revolução Digital estão agora transformando o final deste século assim como a máquina a vapor e a Revolução Industrial transformaram o final do século passado. Satélites, elevadores, carros com injeção eletrônica ou freios ABS, aviões, instrumentos eletrônicos, calculadoras, relógios digitais, celulares, aparelhos de fax, equipamentos médicos, robôs, videocassetes, rádio-relógios, impressoras e, claro, computadores: todos esses aparelhos e equipamentos (além de muitos, muitos outros) possuem microchips.

Mas... e de onde vieram esses pequenos notáveis, quem os inventou e quando? Como funcionam, o que há no interior dessas minúsculas caixas pretas? E por que a era da informação e nossas vidas digitais não seriam possíveis sem o microchip? O microchip não nasceu do dia para a noite. Como a maioria das invenções humanas, levou anos para ser desenvolvido. Exigiu o esforço coletivo de centenas de pessoas que trabalharam dia e noite no seu aperfeiçoamento. Foram inúmeros experimentos, testes e protótipos até que o microchip se tornasse uma realidade.

Mas, para entender sua história é preciso, antes, conhecer uma outra história. A história de um fabuloso dispositivo eletrônico que encontrou lugar em toda a sorte de aparelhos e equipamentos eletrônicos e que mudou drasticamente nossas vidas: o transistor. Desde a hora em que acordamos de manhã até a hora em que vamos para a cama à noite, estamos a todo momento em contato com aparelhos e equipamentos repletos de transistores -- como rádios, televisões, relógios digitais, fornos de microondas, telefones, carros, aviões, etc. Sem falar, é claro, do computador.

Os computadores de hoje possuem diversos microchips, cada um contendo milhares ou até milhões de transistores. Um microprocessador (o chip principal de um computador) como o Pentium II, da Intel, chega a possuir 7,5 milhões deles.

Inventado por cientistas do Bell Telephone Laboratories no dia 16 de dezembro de 1947 -- cinqüenta anos depois da descoberta do elétron por Joseph John Thomson e cem anos depois do nascimento de Alexander Graham Bell -- o transistor valeu aos seus inventores o prêmio Nobel de física de 1956. É citado na edição de janeiro de 1998 da revista Proceedings of the IEEE (edição comemorativa dos 50 anos do transistor) como “a invenção da engenharia elétrica mais revolucionária do século 20, cujo impacto é sentido a todo momento, em todo lugar na era da informação”.

Um substituto para as válvulas

A história do transistor começa há mais de cinqüenta anos, em 1947. A Segunda Guerra havia terminado, e as indústrias de todo o mundo procuravam tomar novos rumos. Armas e equipamentos bélicos não eram mais a prioridade. A economia do pós-guerra trazia novas necessidades. A expansão das telecomunicações e da informática naquele período, por exemplo, era bastante promissora. Contudo, a tecnologia da época não favorecia esse desenvolvimento potencial. Sistemas telefônicos, equipamentos de telecomunicações e computadores empregavam um grande número de dispositivos amplificadores e comutadores. Mas os sistemas eletromecânicos disponíveis eram lentos, pouco confiáveis e dissipavam grande quantidade de calor.

Um desses dispositivos eletromecânicos amplamente utilizados era o relê (relay, em inglês). Consistia em um magneto (material sensível a campos magnéticos) que se deslocava unindo dois contatos de metal, que por sua vez fechavam um circuito. Uma pequena quantidade de energia no circuito magnético podia controlar uma grande quantidade de energia no circuito de contato. O dispositivo era relativamente simples, resistente e bastante confiável -- uma excelente chave (interruptor, comutador). A limitação dos relês era sua velocidade -- levavam cerca de um milésimo de segundo para abrir ou fechar um contato (o que em sistemas de telecomunicações é uma eternidade).

Havia ainda a válvula (vacuum tube, em inglês), cujo funcionamento baseava-se no fluxo de elétrons no vácuo. A válvula era basicamente uma capsula de vidro contendo um filamento aquecido que emitia elétrons. Esses elétrons ejetados eram coletados em uma placa positivamente carregada. O fluxo de elétrons do filamento era controlado por uma pequena tensão elétrica em um eletrodo localizado entre o filamento (anodo) e a placa (catodo), chamado grade. A válvula podia comutar e amplificar, e como os elétrons podiam viajar velozmente no vácuo, era bem mais rápida que o relê (cerca de um milhão de vezes mais rápida). Mas o problema é que as válvulas exigiam fornecimento de energia constante e sua vida útil era bastante limitada. Assim, a válvula era boa em aplicações que empregavam um pequeno número delas, como nos rádios. Onde milhares eram necessárias, como em computadores, a válvula não era adequada.

Desvendando os semicondutores

A busca de tecnologias alternativas foi uma conseqüência natural. Cientistas em laboratórios de todo o mundo estavam em busca de um dispositivo eletrônico que substituísse relês e válvulas. Na época, os cientistas estudavam as propriedades elétricas de todo tipo de material. Submetiam amostras a dezenas de testes e classificavam os materiais em dois grupos: aqueles que conduziam eletricidade, os condutores, e aqueles que não conduziam, os isolantes -- ou dielétricos. Mas, depois de muitos testes, uma surpresa: alguns materiais não se comportavam nem como condutores nem como isolantes: ora conduziam corrente elétrica ora a bloqueavam. Descobriu-se os semicondutores e surgiu finalmente uma alternativa tecnológica interessante para os relês e válvulas. Percebeu-se que esse comportamento conduz/não conduz dos semicondutores podia ser usado para construir comutadores e moduladores eletrônicos. A grande expectativa era que o emprego de dispositivos construídos com semicondutores prometia inúmeras vantagens: elétrons viajando pequenas distâncias em um sólido, nada de partes móveis, nada de filamentos aquecidos e nada de vácuo. Deveria então ser rápido, barato e confiável.

No verão de 1945, um grupo de pesquisa neste campo foi organizado no Bell Telephone Laboratories em Murray Hill, estado de New Jersey, nos Estados Unidos. A iniciativa foi do diretor de pesquisas do Bell Labs, Mervin Kelly. Há anos Kelly sonhava em encontrar um substituto eletrônico para os relês do sistema telefônico. Ele havia organizado um programa de pesquisa com esse objetivo na década de 30, mas o trabalho foi interrompido com a guerra. Com o fim da guerra, o programa foi reativado. No início de 1946, o grupo já estava praticamente formado. Um dos líderes era William Shockley, um físico com doutorado no MIT. Faziam parte ainda dois elementos chave no grupo: o engenheiro elétrico John Bardeen e o físico Walter Brattain.

Os cientistas estava surpresos com as pesquisas de dispositivos que empregavam germânio e silício em detetores para radar. Esperava-se descobrir outras propriedades promissoras desses materiais semicondutores. Dessa forma, por volta de janeiro de 1946, duas decisões críticas foram tomadas. A primeira foi a decisão de focalizar a atenção do grupo em cristais de silício e germânio, ignorando outros materiais mais complexos utilizados em outras pesquisas. A segunda decisão consistiu em investigar o efeito de campos elétricos em semicondutores.

Shockley imaginou que seria possível alterar a condutividade de um pequeno bloco de germânio aplicando sobre sua superfície um campo elétrico adequado. Esse campo poderia modificar a distribuição de cargas elétricas no corpo do semicondutor e, consequentemente, alterar sua capacidade de conduzir eletricidade. Tipicamente, o campo era criado aplicando-se uma tensão a uma placa de metal próxima, porém isolada, do material semicondutor. Variando-se a tensão na placa de metal, podia-se variar a corrente fluindo através do semicondutor, obtendo-se assim um ganho de potência. Contudo, todas as tentativas nesse sentido foram frustradas.

Foi Bardeen quem descobriu por quê. Ele sugeriu que o campo elétrico aplicado não penetrava apropriadamente no semicondutor. Isso devia-se a cargas elétricas imóveis, situadas na superfície do material. Essas cargas, embora em número reduzido, acabavam por criar uma blindagem que “protegia” o semicondutor do campo elétrico aplicado. Brattain conduziu experimentos que confirmaram o modelo proposto por Bardeen. Finalmente algum progresso era feito.

A invenção do transistor

Os pesquisadores do Bell Labs tentaram, então, encontrar formas de minimizar o efeito das cargas na superfície. Tentaram diversos tipos de montagens e configurações a fim de verificar o tão esperado efeito de campo. No dia 16 de dezembro de 1947, em uma dessas montagens, Brattain utilizou dois contatos de ouro separados por apenas alguns milímetros e pressionados contra a superfície de um pequeno bloco de germânio. Com as devidas tensões elétricas aplicadas, os cientistas verificaram que uma corrente elétrica fluía pelo material semicondutor, configurando assim o efeito de amplificação tão desejado (efeito transistor). O primeiro transistor construído por Bardeen e Brattain ficou conhecido como transistor de ponto de contato. Esse transistor fazia o trabalho de uma válvula termoiônica sem requerer um anodo de alta tensão e um catodo em alta temperatura capaz de ejetar elétrons. Além disso, não precisava de invólucro -- uma capsula de vidro -- como a válvula, e era bem menor do que esta.

Os pesquisadores do Bell Labs tentaram, então, encontrar formas de minimizar o efeito das cargas na superfície. Tentaram diversos tipos de montagens e configurações a fim de verificar o tão esperado efeito de campo. No dia 16 de dezembro de 1947, em uma dessas montagens, Brattain utilizou dois contatos de ouro separados por apenas alguns milímetros e pressionados contra a superfície de um pequeno bloco de germânio. Com as devidas tensões elétricas aplicadas, os cientistas verificaram que uma corrente elétrica fluía pelo material semicondutor, configurando assim o efeito de amplificação tão desejado (efeito transistor). O primeiro transistor construído por Bardeen e Brattain ficou conhecido como transistor de ponto de contato. Esse transistor fazia o trabalho de uma válvula termoiônica sem requerer um anodo de alta tensão e um catodo em alta temperatura capaz de ejetar elétrons. Além disso, não precisava de invólucro -- uma capsula de vidro -- como a válvula, e era bem menor do que esta.

No dia 24, o dispositivo foi apresentado à diretoria do Bell Labs, desta vez funcionando como um oscilador (a oscilação é uma característica fundamental em telecomunicações, sendo usada em equipamentos de geração e recepção de sinais).

Contudo, ainda não se entendia perfeitamente o funcionamento do dispositivo. Seria um efeito de superfície ou a ação estava ocorrendo no corpo do semicondutor? Bardeen e Brattain continuaram pesquisando os efeitos na superfície. Shockley, contudo, havia percebido a importância da movimentação de cargas elétricas no interior do semicondutor. No final de janeiro de 1948, ele completou a formulação teórica de um dispositivo semicondutor que mais tarde seria chamado de “transistor de junção”.

O anúncio da descoberta do transistor, contudo, foi adiado até junho de 1948. Estes seis meses foram gastos pesquisando-se mais sobre o dispositivo, buscando entendê-lo melhor e investigando suas possíveis aplicações. O objetivo era obter uma posição melhor para o registro das patentes. No dia 17 de junho de 1948, Bardeen e Brattain entraram com um pedido de patente para o transistor de ponto de contato. No dia 26, Shockley registrou um pedido de patente para o seu transistor de junção. Até então, o transistor era um segredo do Bell Labs.

No dia 30 de junho de 1948, o transistor de Brattain e Bardeen foi demonstrado para a imprensa nas instalações do Bell Labs em Nova York. A imprensa comum deu pouca atenção, mas a imprensa especializada reconheceu sua importância. O jornal The New York Times reportou a história quase na última página no dia 1º de julho de 1948 na sua coluna “As Notícias do Rádio”:

Leia também - 64 Bits - O Futuro

“Um dispositivo chamado transistor, com inúmeras aplicações no rádio, onde as válvulas são amplamente empregadas, foi demonstrado pela primeira vez ontem no Bell Telephone Laboratories, na rua West, 463, onde foi inventado. O dispositivo foi usado num receptor de rádio, que não continha nenhum tipo de válvula convencional. Foi mostrado também num sistema telefônico e num aparelho de televisão controlado por um receptor colocado no piso inferior. Em cada caso, o transistor foi empregado como amplificador, embora seja dito que ele possa ser usado também como oscilador, de forma a criar e enviar ondas de rádio. No formato de um pequeno cilindro metálico com pouco mais de meia polegada de comprimento, o transistor não contém vácuo, grade, placas ou invólucro de vidro para manter o ar afastado. Sua ação é instantânea, não havendo atrasos por aquecimento, uma vez que não é gerado calor como em uma válvula. As partes funcionais do dispositivo consistem somente de dois finos fios que se ligam a uma placa de material semicondutor soldada a uma base de metal. O material na base de metal amplifica a corrente que chega até ela por um dos fios. O outro fio conduz a corrente amplificada.”

Em 15 de julho de 1948, a revista especializada Physical Review publicou três artigos sobre o transistor: dois de Brattain e Bardeen e um de Shockley. Foram os primeiros artigos técnicos amplamente difundidos explicando os princípios básicos do novo dispositivo.

Do laboratório para a indústria

Mais alguns anos se passaram e outros experimentos e descobertas se sucederam. Assim, num período de poucos anos após o estabelecimento do grupo de semicondutores no Bell Labs, a invenção do transistor estava essencialmente completa, entendida e documentada. (Em 1950, Shockley publicou o livro “Electrons and Holes in Semiconductors”.) A fase científica estava chegando ao fim. A próxima fase consistia em resolver problemas mais práticos para a produção de transistores em grande escala.

Em primeiro lugar, havia dois tipos de transistor que eventualmente poderiam ser fabricados: o transistor de ponto de contato e o transistor de junção. O transistor de ponto de contato tinha muitas desvantagens. Era difícil de fabricá-lo e suas características elétricas estavam longe de ser ideais -- eram muito variáveis, difíceis de ser controladas e inerentemente instáveis. O transistor de junção, por outro lado, tinha características elétricas mais desejáveis e estáveis. Sua fabricação, contudo, também era bastante complexa; exigia técnicas bastante apuradas e sensíveis, sendo difícil automatizar a produção.

Havia ainda muitos outros problemas, como conseguir que o transistor funcionasse em altas freqüências, como as válvulas, e que fosse capaz de suportar potências elevadas, como os relês. Para operar em altas freqüências, os transistores deviam ser pequenos, mas para suportar elevada potência, tinham que ser grandes. Além das dificuldades tecnológicas, havia uma inércia muito grande por parte da indústria para aceitar o transistor. Os engenheiros e técnicos da época já estavam acostumados com as válvulas, cujo funcionamento era relativamente simples e intuitivo. Já o transistor era um componente complexo, seu funcionamento envolvia até física quântica. Era natural que surgisse um clima de insegurança frente à necessidade de aprender novas técnicas de projeto e construção de circuitos eletrônicos. Algumas companhias chegaram a afirmar que o transistor, devido a sua baixa confiabilidade e sujeição inerente a ruídos, nunca iria substituir a válvula.

Além disso, o transistor ainda era mais caro do que as válvulas, que dominavam completamente a indústria. Com poucas exceções, os fabricantes de válvulas não estavam nada entusiasmados com o transistor. O equipamento para a produção das válvulas já estava em boa parte amortizado, então a fabricação de válvulas era uma máquina de ganhar dinheiro.

Mas, aos poucos, o transistor e sua fabricação foram sendo aprimorados e suas vantagens sobre as válvulas tornavam-se cada vez mais evidentes. Algumas empresas ainda tentavam resistir. Na época, a RCA chegou a introduzir uma pequena válvula de baixa tensão chamada “Nuvistor”. Tinha um invólucro de cerâmica e era pouco maior que os transistores da época. Mas foi uma batalha perdida. O Nuvistor foi empregado por um curto período em aparelhos de TV da RCA, e em seguida desapareceu juntamente com a maioria das outras válvulas à medida que a era do estado sólido emergiu.

Dessa forma, os primeiros fabricantes de transistores eram na sua maioria fabricantes de válvulas. Contudo, algumas empresas iniciantes foram bem-sucedidas. Talvez o maior exemplo seja a Texas Instruments, que na época fabricava instrumentos geofísicos. A companhia viu uma grande oportunidade nos transistores e, em 1953, obteve uma licença do Bell Labs, estabeleceu um laboratório próprio e chamou pesquisadores de renome para conduzi-lo. Um ano depois, a Texas Instruments anunciou o primeiro transistor de silício. O silício apresentava diversas vantagens sobre o germânio: suas características elétricas eram melhores, podia suportar muito mais potência e podia operar em uma faixa de temperatura ambiente bem mais ampla, além de haver suprimento de matéria prima praticamente infinito. As desvantagens do silício eram seu ponto de fusão elevado (que exigia processos metalúrgicos mais complexos) e o fato de o silício ser mais reativo quimicamente do que o germânio (o que facilitava a contaminação). Essas dificuldades, contudo, foram logo superadas e a fabricação de dispositivos de silício tornou-se dominante. Com o advento do transistor de silício, a Texas Instruments tornou-se instantaneamente uma poderosa concorrente no mercado.

Além disso, para combater a resistência da indústria contra o transistor, foi decisiva a atuação do Bell Labs no sentido de promover uma ampla difusão de informações sobre o dispositivo. Em 1951 e 1952 foram organizados simpósios para interessados do governo, indústria e do meio acadêmico. A idéia era divulgar as técnicas de fabricação de transistores e esclarecer detalhes sobre seu funcionamento. Além disso, por apenas 25 mil dólares, conseguia-se do Bell Labs a licença para produzir transistores. Mas, poderíamos nos perguntar: por que o Bell Labs não manteve essa valiosa invenção como uma propriedade exclusiva sua? Por que concedia a licença para fabricação de transistores por tão pouco? Qual era a intenção da empresa ao promover a disseminação do dispositivo? A idéia por trás dessa estratégia aparentemente insensata era que outras empresas entrassem no negócio, alavancando o setor e desenvolvendo novas tecnologias que pudessem ser empregadas nos sistemas de telecomunicações. O Bell Labs certamente ganharia muito dinheiro com isso. Um outro motivo era a forte cultura de troca informações na indústria de semicondutores, embora essa indústria fosse bastante competitiva. O rápido progresso na fabricação de transistores deveu-se em grande parte ao intenso intercâmbio tecnológico entre companhias, centros de pesquisa do governo e laboratórios de universidades.

O início da década de 50 foi marcado por rápidas melhorias nas características e na fabricação de transistores. Avanços sucediam-se rapidamente e os novos dispositivos eram capazes de operar em freqüências cada vez maiores -- 100 MHz ou mais. Alguns pesquisadores desenvolviam outros tipos de dispositivos semicondutores, e finalmente foi construído o transistor por efeito de campo (tecnologia batizada de FET -- field effect transistor). Os primeiros JFETs (junction field effect transistors) foram produzidos pela Crystalonics em Cambridge, Massachusetts, em 1960.

O transistor espalha-se pelo mundo

Tendo superado as dificuldades de fabricação em larga escala do transistor, era hora de empregá-lo na prática, buscando substituir a válvula no maior número de aplicações possível. Essa não era uma tarefa fácil, já que os transistores eram então fabricados em tamanhos reduzidos, o que dificultava sua capacidade de suportar altas potências. Além disso, não suportavam freqüências de operação tão elevadas quanto às das válvulas.

Enquanto isso, outras iniciativas tomavam corpo e mais tarde fariam surgir aquilo que hoje conhecemos como Vale do Silício (Silicon Valley). Em 1954, William Shockley deixou o Bell Labs e mudou-se para Palo Alto, uma pequena cidade no estado da Califórnia, Estados Unidos, onde iniciou sua própria companhia, a Shockley Semiconductor Laboratory. Para levá-la adiante, Shockley contratou um grupo de físicos e engenheiros jovens e ambiciosos de companhias de eletrônicos da costa leste dos EUA -- incluindo um grupo de oito pesquisadores que logo deixariam sua marca na história da microeletrônica, embora sem a companhia de Shockley.

Os oito -- Julius Blank, Victor Grinich, Jean Hoerni, Eugene Kliner, Jay Last, Gordon E. Moore, Robert N. Noyce e Sheldon Roberts -- não conseguiram se entender com Shockley e com sua maneira de conduzir os negócios. Depois de dois anos, em 1957, saíram para formar sua própria companhia. Nasceu assim a Fairchild Semiconductor (hoje conhecida por originar uma série de outras empresas sediadas na Vale do Silício). Com a saída em massa, a companhia de Shockley acabou perdendo o rumo e depois de ter sido comprada por duas vezes, acabou fechando as portas em 1969.

A Fairchild iniciou logo suas atividades e introduziu e aperfeiçoou processos e técnicas com sucesso. Entre as inovações bem-sucedidas, estava a fabricação de transistores utilizando um processo chamado de difusão. Consistia em envolver o material semicondutor em um gás contendo determinados elementos químicos (chamados de impurezas). Em seguida, variava-se a temperatura de modo que as impurezas penetrassem no semicondutor. Tal processo permitia controlar com precisão a penetração de impurezas no semicondutor. Com isso, podia-se criar no semicondutor regiões bastante finas dopadas com impurezas. Essas regiões dotadas de diferentes propriedades elétricas é que tornavam o efeito transistor possível. A espessura da base (uma dessas regiões) era importante para que o transistor funcionasse com freqüências elevadas.

Dessa forma, apesar de a lâmina de semicondutor ter de ser grossa o suficiente para ser mecanicamente resistente, a base devia ser bastante fina. Uma base com espessura de 10 mícrons propiciava freqüências de operação de apenas alguns megahertz. Era necessário aperfeiçoar as técnicas de fabricação para se conseguir bases ainda mais estreitas e consequentemente dispositivos que pudessem ser usados nas diversas aplicações eletrônicas. Esse problema foi resolvido com um outro processo: o processo epitaxial. Esta nova técnica aprimorava o processo de difusão, permitindo a fabricação de transistores que suportavam alta freqüência de operação e elevada potência. Logo foram fabricados transistores com freqüências da ordem de centenas de megahertz. O processo de difusão e o processo epitaxial tiveram um impacto fundamental na fabricação de dispositivos semicondutores e foram decisivos para o surgimento dos circuitos integrados.

Outros avanços importantes deram-se com a descoberta de que uma camada de dióxido de silício podia impedir a difusão de certos átomos de impurezas na lâmina de silício. A difusão, contudo, poderia ocorrer desimpedida através de “janelas” na camada de dióxido de silício. Essas descobertas deram início ao emprego de técnicas de fotolitografia para a “impressão” de padrões sobre o silício. Esses padrões podiam determinar as regiões onde a difusão iria ocorrer.

O transistor, contudo, apresentava ainda outros problemas. Era muito sensível a variações de temperatura e umidade. No início tentou-se empregar blindagens de vidro, aproveitando a experiência com a fabricação de válvulas. Mas definitivamente esta não era uma solução adequada. No início de 1958, pesquisadores da Fairchild descobriram como usar o próprio dióxido de silício como uma efetiva proteção que impedisse a degradação do transistor. Essa proteção praticamente resolveu o problema de confiabilidade do dispositivo.

Rumo ao microchip

Todas essas inovações representavam um grande avanço na indústria de semicondutores. Chegava-se a um época promissora. O silício, o semicondutor escolhido, podia ser produzido com pureza e perfeição cristalina mais do que adequadas para seu uso. As dimensões críticas em todas as direções podiam ser controladas com grande precisão. Os contatos elétricos podiam ser feitos com facilidade, sem a necessidade de precisão microscópica. Os dispositivos resultantes mostravam grande confiabilidade. E tudo podia ser feito em larga escala. Passados apenas treze anos de sua invenção, o transistor já podia abrir caminho para outro grande salto tecnológico: a invenção do circuito integrado (popularizado mais tarde como “microchip”), em 1958, por Jack S. Kilby, da Texas Instruments, e Robert N. Noyce, da Fairchild Semiconductor.

Kilby pensava em maneiras de miniaturizar os componentes e simplificar sua fabricação, possivelmente construindo todos eles sobre uma mesma lâmina de silício. Em julho de 1958, ele escreveu em seu caderno de pesquisa: “A miniaturização extrema de muitos circuitos elétricos pode ser alcançada fazendo-se resistores, capacitores, transistores e diodos em uma única lâmina de silício”. Em seguida ele ocupou-se em mostrar nas cinco páginas seguintes como isso poderia ser feito. No final de agosto, uma versão simplificada de seu circuito já estava disponível, demonstrando que era possível produzir transistores, diodos, capacitores e resistores em um único bloco de semicondutor e interconectá-los para criar circuitos funcionais.

O mesmo acontecia em outros locais de pesquisa. No Bell Labs, numa reunião em que se discutia de que forma os transistores iriam substituir as válvulas, um dos pesquisadores disse: “Senhores, vocês entenderam tudo errado! A vantagem do transistor é que ele é um dispositivo inerentemente pequeno e de baixo consumo de energia. Isso significa que você pode agrupar um grande número deles em um espaço pequeno sem geração excessiva de calor e conseguir baixos atrasos de propagação. E é isso que precisamos para aplicações lógicas. O significado do transistor não é que ele pode substituir a válvula, mas que ele pode fazer coisas que a válvula nunca pôde!”

De fato, grande parte da pesquisa em semicondutores, sobretudo aquelas financiadas pelo governo, envolvia a miniaturização de componentes. Essa preocupação devia-se sobretudo à corrida espacial, e ao recente sucesso dos soviéticos no lançamento do satélite Sputnik I (no dia 4 de outubro de 1957). Enquanto isso, na Fairchild, Noyce, de forma independente, dava um passo adiante na forma de interconectar os microcomponentes do circuito integrado. Ele inspirou-se nas técnicas que empregavam dióxido de silício como “máscaras” para a difusão de impurezas. Dessa forma, enquanto o processo de Kilby utilizava pequeninos fios nas conexões entre os componentes do circuito, o processo desenvolvido por Noyce empregava trilhas de alumínio ou ouro que podiam ser aplicadas com a ajuda de máscaras e fotolitografia.

As idéias de Kilby e Noyce tornaram o circuito integrado uma realidade.

Leia também - Pele de tubarão - Shark Skin

Contudo, houve uma certa relutância por parte da indústria de que seria viável produzir circuitos integrados em grande escala. A principal preocupação era quanto à confiabilidade. Por muitos anos, a produção de transistores trabalhou com rendimentos (porcentagem de componentes não-defeituosos) em torno de 20%. Embora bastante baixos, eram números aceitáveis. Com a evolução tecnológica, chegou-se em alguns anos a 90% de rendimento. Mesmo assim, qual seria a confiabilidade de um chip com cem ou até mil transistores? Imaginava-se que seria bastante pequena em função da alta probabilidade de um dos transistores falhar. Mas tal insegurança baseava-se na idéia de que o rendimento dos processos de fabricação de transistores e também sua taxa de falhas eram eventos aleatórios. Contudo, verificou-se que isso não era verdade. O rendimento e a taxa de falhas estavam fortemente relacionados com o próprio processo de fabricação em lote de transistores; isto é, fabricava-se sobre um wafer de silício uma grande porção de componentes em uma única “fornada”. Dessa forma, em determinadas regiões do wafer, conseguia-se ótimo rendimento, praticamente 100%; em outras, contudo, o rendimento era praticamente nulo -- nenhum componente podia ser aproveitado. Assim, se o chip fosse produzido sobre uma região do wafer de elevado rendimento, sua confiabilidade era igualmente elevada.

Durante a década de 60, muitas pesquisas nesse campo se sucederam, levando a processos cada vez mais aperfeiçoados, e que garantiam confiabilidade cada vez maior para os circuitos integrados. Em 1961, apenas 13 anos depois da invenção do transistor, a indústria de semicondutores superou a marca de 1 bilhão de dólares em lucros. Empresas como a Fairchild e a Texas Instruments já produziam circuitos integrados em escala comercial. Seus compradores eram agências do governo, como a Nasa, os militares e também grandes companhias, como a IBM.

Em 1962, o número de companhias participantes se multiplicava. Além da Fairchild e da Texas Instruments, RCA, Sylvania, National Semiconductor e Motorola também entraram no mercado de circuitos integrados. Surgiu a lógica TTL (transistor-transistor logic) e fabricou-se os primeiros amplificadores operacionais em circuito integrado.

Por volta de 1967, a indústria de semicondutores começou a tomar novos rumos que alterariam profundamente o Vale do Silício. Diversos empregados deixaram a Fairchild para ingressar em outras companhias ou ainda para formar suas próprias empresas. Foi neste jogo de cadeiras que Gordon Moore e Robert Noyce deixaram a Fairchild para formar a Intel, levando com eles alguns empregados estratégicos, entre eles Andrew Grove.

A década de 70 foi a década em que a tecnologia MOS (metal-oxide semiconductor) atingiu seu auge, seguida logo pela CMOS (complementary metal-oxide semiconductor), a tecnologia predominante nos chips de hoje. Inicialmente, a tecnologia CMOS foi subestimada, mas os métodos envolvidos foram aperfeiçoados e gradualmente ela tornou-se bastante empregada, miniaturizada, rápida e de baixo consumo de energia. A RCA introduziu o primeiro microprocessador CMOS, o 1802, em 1974. Foi seguido pelo microcontrolador de 4 bits TMS1000, da Texas Instruments.

E assim, novos chips eram lançados continuamente e sua complexidade crescia exponencialmente, tornando possível aplicações cada vez mais surpreendentes. Logo surgiram os primeiros microprocessadores, complexos microchips capazes de executar milhões de instruções por segundo. Os microprocessadores possibilitaram a fabricação de computadores cada vez mais poderosos. Hoje, vivemos uma época em que os microchips tornaram-se ubíquos -- estão em toda parte, a todo instante -- e desempenham um papel fundamental em nossas vidas, facilitando o trabalho, a comunicação, o entretenimento. Sem eles, nossas “vidas digitais” seriam impossíveis

Como funcionam

O microchip hoje pode ser considerado uma verdadeira “caixa preta”. Encontramos esse diminuto dispositivo por toda parte, mas simplesmente não sabemos como funcionam. Então, afinal, o que se passa dentro deles? Em primeiro lugar é preciso dizer que existem hoje milhares de tipos de microchips. Alguns são mais simples -- como os que fazem funcionar um relógio digital --, outros são mais complexos -- como o microprocessador de um computador.

Todos eles são bastante diferentes entre si, mas de modo geral podemos dizer que um microchip não passa de um circuito eletrônico miniaturizado. Esse circuito, por sua vez, é composto por diversos componentes eletrônicos, sendo capaz de realizar uma determinada função. O chip de um relógio digital, por exemplo, possui um circuito eletrônico capaz de “marcar” o tempo (com grande precisão), exibindo o horário corrente num visor. Já o chip de freios ABS contém um circuito eletrônico capaz de monitorar a rotação das rodas e impedir seu travamento.

Mas a pergunta permanece: e como os microchips são capazes de desempenhar essas funções? E o que há dentro deles?

Sintonizando as ondas do rádio

O elemento principal de um microchip é o transistor. Dentro de um pequeno microchip pode haver desde uma dúzia até alguns milhões de transistores. Os transistores são arranjados de forma a criar blocos funcionais que uma vez interligados tornam o chip capaz de realizar algum tipo de processamento. Mas, para entendermos o funcionamento dos transistores -- os componentes principais do microchip --, devemos retroceder na História e refazer parte do caminho percorrido pela eletrônica. Devemos voltar ao tempo das válvulas e relês…

Em 1883, o conhecido inventor Thomas Alva Edison (1847-1931) estava em seu laboratório trabalhando com lâmpadas elétricas de filamento quando um fenômeno curioso lhe chamou a atenção. Uma placa metálica havia sido introduzida na parte superior de uma lâmpada elétrica comum, bem em frente ao filamento metálico. Acendendo a lâmpada e ligando a placa metálica ao pólo positivo de uma bateria e o filamento da lâmpada ao pólo negativo, era possível medir uma corrente elétrica fluindo. Na época, Edson não soube explicar o que estava acontecendo. Como poderia haver tal corrente elétrica se a placa metálica estava isolada, isto é, não encostava no filamento? O que estava “fechando o circuito” entre a placa e o filamento?

Hoje se sabe que tal fenômeno (chamado “efeito termoiônico”) deve-se ao fato de o filamento emitir uma grande quantidade de elétrons que são atraídos pela placa, estabelecendo assim uma corrente elétrica. O efeito termoiônico deve-se à estrutura atômica dos metais. Todo corpo metálico possui elétrons livres que, a qualquer temperatura, possuem um movimento desordenado em virtude de sua agitação térmica. À temperatura ambiente, os elétrons não conseguem se libertar-se do metal porque são atraídos pelos íons positivos da rede cristalina e não possuem energia suficiente para vencer esta atração. Contudo, se a temperatura do corpo for aumentada, a agitação térmica dos elétrons também aumentará e um grande número deles conseguirá escapar da atração dos íons positivos. Estes elétrons que escapam do material passam a formar uma nuvem eletrônica próxima à superfície do corpo. Se houver um outro corpo metálico positivamente carregado próximo a essa nuvem, os elétrons serão atraídos e uma corrente elétrica se estabelecerá.

Algum tempo depois, um físico inglês, John Ambrose Fleming, percebeu que a descoberta de Edison podia ser bastante útil para melhorar a recepção de sinais de rádio. Na época, já se conseguia gerar ondas de rádio para transmitir informação; a grande dificuldade era a recepção dos sinais. No início, utilizava-se certos tipos de cristais capazes de conduzir corrente elétrica em um determinado sentido. Eram chamados “cristais retificadores” e serviam para separar a onda portadora da informação que ela carregava. A idéia de Fleming era utilizar o efeito termoiônico em dispositivos que viessem a substituir os cristais retificadores. Esses dispositivos ficaram conhecidos como “válvulas termoiônicas”.

As primeiras válvulas eram do tipo “diodo” (possuíam dois eletrodos) e nada mais eram do que uma adaptação da lâmpada com a qual Edison descobriu o efeito termoiônico. Consistiam de um cilindro metálico (o catodo, isto é, o eletrodo negativo), que era aquecido por meio de um filamento existente em seu interior. Este cilindro era envolvido por outro, também metálico, que constituía o anodo da válvula (o eletrodo positivo). Aplicando-se uma tensão elétrica aos dois eletrodos, os elétrons que eram emitidos pelo catodo aquecido em virtude do efeito termoiônico dirigiam-se para o anodo. Os eletrodos eram envolvidos em uma cápsula (geralmente de vidro) e no seu interior era feito vácuo -- a fim de facilitar o deslocamentos dos elétrons.

As válvulas diodo, desde sua invenção, passaram a ser amplamente empregadas em circuitos eletrônicos. Assim como os cristais retificadores, era possível, com elas, separar uma onda portadora da informação carregada por ela. O passo seguinte no aperfeiçoamento das válvulas foi dado pelo norte-americano Lee de Forest (1873-1961). Ele adicionou um novo componente à válvula de Fleming: era um terceiro eletrodo, chamado grade -- uma rede ou espiral de pequeninos fios envolvendo o catodo. O potencial negativo da grade controlava o fluxo dos elétrons do catodo para o anodo. Quanto menor o potencial negativo da grade, mais elétrons podiam fluir através da válvula. Ou seja, a grade funcionava como uma espécie de controle de corrente elétrica na válvula -- como uma torneira que controla o fluxo de água. Dessa forma, era possível injetar na grade um sinal bem fraco (como o que chega de uma antena) e obter um sinal praticamente idêntico, porém bem mais forte, entre o catodo e o anodo. Em outras palavras, era possível utilizar a válvula como um dispositivo amplificador. Por possuir agora três eletrodos, esse tipo de válvula termoiônica ficou conhecida como “triodo”.

A válvula triodo de de Forest representou um grande avanço para a engenharia eletrônica. Com esse dispositivo amplificador foi possível aperfeiçoar não apenas rádios, mas também equipamentos telefônicos e televisores. As válvulas permitiram até a construção dos primeiros computadores totalmente eletrônicos, isto é, sem partes eletromecânicas móveis.

Apesar de todo o avanço na área da eletrônica, as válvulas estavam longe de ser perfeitas. Pelo contrário, elas tinham muitos defeitos e traziam muita dor de cabeça para os engenheiros da época. Em primeiro lugar, eram relativamente grandes, se comparadas com outros componentes dos circuitos eletrônicos. Em segundo lugar, não duravam muito e eram pouco confiáveis (o filamento podia queimar ou o encapsulamento podia rachar, comprometendo o vácuo). Além disso, devido ao filamento aquecido, as válvulas consumiam muita energia e dissipavam muito calor. Equipamentos com muitas válvulas eram um grande problema, pois a qualquer momento uma delas podia se queimar…

Nem condutores nem isolantes

Os problemas das válvulas motivaram alguns pesquisadores a procurar soluções alternativas. Resultados promissores começaram a ser encontrados com o uso de materiais chamados semicondutores (principalmente silício e germânio). São materiais que não podem ser classificados nem como condutores nem como isolantes, situando-se pois num grupo intermediário. Trabalhando com esses materiais, alguns cientistas descobriram que a adição de quantidades muito pequenas de certas sustância (chamadas impurezas) a um semicondutor pode alterar consideravelmente suas propriedades elétricas. Assim, adicionando-se uma pequena quantidade de fósforo a uma amostra de silício, obtém-se um condutor elétrico semelhante a um metal, isto é, a condução elétrica nesta substância é feita por meio de elétrons livres. Dizemos que um semicondutor como este é do tipo n (condução feita por cargas negativas). Por outro lado, se uma pequena quantidade de boro é adicionada ao silício puro, verifica-se que ele também conduz eletricidade, mas tudo se passa como se a corrente elétrica fosse constituída pelo movimento de cargas positivas. Por este motivo, dizemos que o silício dopado com boro é um semicondutor do tipo p (condução por cargas positivas).

Os problemas das válvulas motivaram alguns pesquisadores a procurar soluções alternativas. Resultados promissores começaram a ser encontrados com o uso de materiais chamados semicondutores (principalmente silício e germânio). São materiais que não podem ser classificados nem como condutores nem como isolantes, situando-se pois num grupo intermediário. Trabalhando com esses materiais, alguns cientistas descobriram que a adição de quantidades muito pequenas de certas sustância (chamadas impurezas) a um semicondutor pode alterar consideravelmente suas propriedades elétricas. Assim, adicionando-se uma pequena quantidade de fósforo a uma amostra de silício, obtém-se um condutor elétrico semelhante a um metal, isto é, a condução elétrica nesta substância é feita por meio de elétrons livres. Dizemos que um semicondutor como este é do tipo n (condução feita por cargas negativas). Por outro lado, se uma pequena quantidade de boro é adicionada ao silício puro, verifica-se que ele também conduz eletricidade, mas tudo se passa como se a corrente elétrica fosse constituída pelo movimento de cargas positivas. Por este motivo, dizemos que o silício dopado com boro é um semicondutor do tipo p (condução por cargas positivas).

Leia também - Kevlar

Os cientistas foram além e começaram a colocar lado a lado amostras de silício tipo p e amostras de silício tipo n, formando “junções pn”. Ligando-se uma bateria a um cristal pn de modo que o contato do pólo negativo desta bateria seja feito com o lado p e o pólo positivo com o lado n, observa-se um grande aumento das cargas positivas e negativas existentes na interface da junção. Este fato impede que a corrente atravesse o cristal pn, e ele se compara a um material isolante. Entretanto, invertendo-se a polaridade da bateria -- o pólo positivo sendo ligado ao lado p e o negativo ao lado n --, haverá uma diminuição considerável das cargas elétricas na junção. Nestas condições, a corrente elétrica pode fluir pelo cristal pn.

É fácil observar que o comportamento de uma junção pn se assemelha ao de uma válvula diodo, deixando passar corrente elétrica em um sentido (de p para n), e impedindo a passagem no sentido contrário (de n para p). Surgiu assim o diodo semicondutor, bem mais econômico, confiável e durável do que as válvulas diodo. Logo foi a vez da válvula triodo ser substituída por um dispositivo semicondutor. Descobriu-se que um cristal semicondutor com duas junções (pnp ou npn) era capaz de produzir amplificações semelhantes àquelas conseguidas com as válvulas. Em outras palavras, uma pequena corrente na camada central (como um sinal de rádio que viajou grandes distâncias) era capaz de controlar o fluxo maior de corrente entre as duas outras camadas. Dessa forma, a corrente mais forte “imitava” o comportamento da corrente mais fraca. O resultado era uma versão amplificada do sinal fraco. Esse triodo semicondutor foi chamado de transistor.

Transistor: o pequeno notável

O transistor pode ser empregado de muitas maneiras, mas basicamente ele desempenha duas funções: amplificação e chaveamento. No caso da amplificação, podemos fazer uma analogia com uma torneira: girando a torneira, podemos controlar o fluxo de água, tornando-o mais forte ou mais fraco. No caso do chaveamento, podemos imaginar o transistor como um interruptor de luz: ligando o interruptor, a luz se acende; desligando o interruptor, a luz se apaga. Da mesma forma que a torneira controla o fluxo de água, o transistor controla o fluxo de corrente elétrica. E da mesma forma que o interruptor “chaveia” (liga ou desliga) a luz, o transistor pode chavear corrente elétrica. A grande diferença, contudo, da torneira e do interruptor para o transistor é que nos dois primeiros o controle é feito pelas nossas mãos. Já no transistor, o controle da amplificação e do chaveamento é feito por corrente elétrica. Ou seja, no transistor temos corrente elétrica controlando corrente elétrica.

Isso é importante por diversos motivos: em primeiro lugar, com o controle sendo feito por corrente elétrica, consegue-se num transistor uma velocidade de operação milhares de vezes mais rápida do que nossas mãos. Em segundo lugar, o transistor pode ser acoplado a outras fontes de sinal elétrico, como uma antena, um microfone, ou mesmo um outro transistor. Por fim, sendo controlado por corrente, o transistor pode funcionar como uma “chave eletrônica”, sem partes móveis, muito mais rápida e eficiente do que os antigos relês (chaves eletromecânicas).

O transistor representou mais um salto na história da eletrônica. Sendo bem mais confiável, durável, barato e menor do que as válvulas (além de consumir pouquíssima energia e dissipar bem menos calor), tornou-se possível aperfeiçoar e reduzir consideravelmente de tamanho uma série de equipamentos eletrônicos, como aparelhos de rádio e televisão. Hoje, o número de aparelhos e equipamentos que possuem transistores é enorme. Telefones celulares, CD players, sistemas GPS, aparelhos de fax, copiadoras, scanners, câmeras de vídeo, caixas eletrônicos de bancos, equipamentos de ultrassom, airbags, satélites e muitos outros -- todos possuem transistores! Sem o transistor, com certeza o mundo seria bastante diferente.

Traduzindo o mundo analógico em informações digitais

Boa parte da evolução tecnológica sempre caminhou no sentido de facilitar nossas vidas. Muitas máquinas e equipamentos, por exemplo, foram construídas para ampliar nossas capacidades de deslocamento e comunicação. Mas a interação do homem com a realidade está longe de ser simples. Em nossas tentativas de atuar sobre o mundo, temos que desenvolver representações da realidade. A manipulação de informação, por exemplo, requer um sistema de codificação. Foi o que fez o americano Samuel Morse, em 1837, quando inventou o telégrafo elétrico. A transmissão das mensagens (informação) se dava por meio de um código (o conhecido código Morse) que utilizava apenas dois símbolos (traços e pontos) para representar as letras do alfabeto.

Com os computadores não é diferente. Para que possam processar informações foi preciso desenvolver um código, uma “linguagem” própria dos computadores. Esse código é o código binário que, assim como o código Morse, emprega dois elementos (o zero e o um, chamados “bits”) para representar toda a sorte de informações que um computador pode armazenar, processar e exibir.

Pode-se dizer que a idéia de representar dados e realizar operações de transformação sobre eles utilizando para tanto um dispositivo físico surgiu há mais de cinco mil anos, no Oriente, com a invenção do ábaco. O ábaco era capaz de realizar operações aritméticas baseadas em métodos similares aos dos computadores modernos. Desde então, inúmeros mecanismos foram desenvolvidos com o objetivo de computar algum tipo de informação. Em 1805, Joseph-Marie Jacquard construiu uma máquina automática de tear capaz de criar desenhos bastante elaborados. Tais desenhos eram “codificados” em cartões perfurados que eram lidos pela máquina. Em 1932, Charles Babbage e Ada Lovelace conceberam um dos primeiros computadores programáveis da História, a Máquina Analítica, que nunca foi terminada. Em 1847, George Boole publicou seus primeiros trabalhos sobre lógica simbólica -- que mais tarde dariam origem à lógica e à aritmética binária (cuja essência é a resolução de problemas complicados por meio de operações simples).

Em 1938, Claude Shannon adaptou a aritmética binária de Boole para a análise e descrição de circuitos. Nesses circuitos, a posição dos contatos dos relês comporta-se como uma variável booleana, que só pode assumir um de dois estados possíveis, neste caso, aberto ou fechado. Essa adaptação passou a ser conhecida como “álgebra de chaveamento” e os valores possíveis das variáveis, 0 ou 1, passaram a representar condições físicas: ligado ou desligado, com tensão alta ou com tensão baixa, aberto ou fechado, entre várias outras. Em sua tese de mestrado no MIT, Shannon escreveu: “Qualquer expressão composta pelas operações de soma, multiplicação e negação (inversão) representa explicitamente um circuito que contém apenas ligações em série e em paralelo.” Com a álgebra de chaveamento tornou-se possível projetar circuitos lógicos isolados do mundo físico da eletrônica. São circuitos que existem como abstrações matemáticas, como associações de módulos lógicos funcionais que, por sua vez, são associações de portas lógicas simples. As portas lógicas são módulos básicos de circuitos que realizam as operações booleanas.

A implementação física de circuitos lógicos tem passado por muitas transformações. No século passado, a engenharia desses mecanismos se restringia à mecânica. Era o caso dos teares de Jacquard e da Máquina Analítica de Babbage. A lógica através de engrenagens também é antiga. Pascal e Leibniz construíram calculadores mecânicas ainda no século 17. No início deste século, a grande demanda pelos circuitos lógicos se dava na construção de centrais telefônicas. Nessa fase, a melhor opção técnica disponível eram os relês. Um relê é um dispositivo eletromecânico composto por uma bobina e contatos. A bobina é um solenóide que, ao ser percorrido por uma corrente elétrica de amplitude adequada, energiza-se e movimenta os contatos. Pela interligação dos contatos, pode-se realizar as mais diversas funções lógicas: associando-se contatos em série, realiza-se a operação “and”, e em paralelo, a operação “or”. Na década de 30, surgiram os primeiros computadores eletromecânicos, como o Mark I e Mark II da Universidade Harvard. Com a invenção das válvulas, surgiu uma alternativa melhor para a realização de operações lógicas, e ao longo da década de 40, diversos computadores eletrônicos empregando válvulas foram construídos.

Mas foi o transistor que veio revolucionar a eletrônica digital. Finalmente tinha-se um dispositivo barato, confiável e de tamanho reduzido capaz de realizar operações de chaveamento. Em outras palavras, era possível, com o transistor, implementar fisicamente circuitos lógicos digitais cada vez mais complexos e interessantes. Em 1955, a IBM introduziu sua primeira calculadora transistorizada, contendo mais de dois mil transistores. A miniaturização da eletrônica não parou e mais um salto tecnológico se sucedeu com a invenção dos circuitos integrados (microchips).

Um microchip nada mais é do que um aglomerado de transistores (além de outros componentes eletrônicos menos importantes). Estão organizados de tal forma que a saída de um transistor controla outros transistores, que por sua vez controlam outros e assim por diante. Podem ser necessários diversos transistores interconectados para que se consiga realizar operações tão elementares como adicionar um mais um. Mas coloque-se transistores suficientes juntos de maneira apropriada e eles serão capazes de realizar operações complexas com grande velocidade (podem chavear milhões de vezes por segundo ou mais).

Graças às técnicas como a fotolitografia e o desenho assistido por computador (CAD), milhões de transistores e outros componentes eletrônicos, e toda sua interligação, podem ser arranjados em um circuito integrado do tamanho de um pequeno selo. Nessa escala, o custo de um único transistor é praticamente nulo -- cerca de centenas de milionésimos de centavo cada. Com as antigas válvulas em miniatura, o maior número de dispositivos que se conseguia ligar em circuitos eletrônicos correspondia a uma densidade média de 1 elemento por cm3. Com o uso de dispositivos semicondutores, conseguiu-se colocar uma média de até 3 elementos por cm3. Atualmente, com o uso dos circuitos integrados, foi possível atingir a fantástica cifra de 30.000 elementos por cm3. Sem esse desenvolvimento tecnológico, que permitiu tal miniaturização dos circuitos eletrônicos, um moderno computador teria dimensões tão exageradas que sua construção seria inviável.

Um mundo de microchips

Hoje os microchips estão por todo o lado. Tornaram-se uma “tecnologia invisível” que é parte de quase todo equipamento eletrônico. Não é possível ignorá-los. Pelo contrário, devemos entendê-los. Não podemos considerá-los “caixas pretas”, mágicas, que funcionam misteriosamente. Devemos compreender minimamente seu funcionamento, e saber que não existe mistério nenhum: o microchip é apenas mais uma das maravilhosas criações humanas

A Era da Infoermação

No dia 16 de dezembro de 1947, nasceu a revolução digital. Foi em Murray Hill, estado de New Jersey, EUA, quando dois cientistas do renomado Bell Laboratories construíram um estranho dispositivo com alguns contatos de ouro, um pequeno pedaço de material semicondutor e um clipe de metal dobrado. A invenção era capaz de amplificar uma corrente elétrica ou ainda ligá-la e desligá-la, como um interruptor. Nascia assim o transistor.

Sem perceber, nossas vidas foram moldadas por esse estranho dispositivo que a maioria de nós nem sabe como funciona. Mais ainda, hoje, milhões de transistores podem ser construídos minuciosamente em pequeninas placas de silício. São os circuitos integrados, ou microchips. Nos microchips, toda a informação e entretenimento do mundo podem ser armazenados em formato digital, processados e enviados a qualquer canto deste planeta interconectado. Mas nem sempre as coisas foram assim…

A velocidade das transformações

Por milhares de anos, os homens pré-históricos viveram da caça de animais selvagens e da coleta de plantas e frutas fornecidas pela Natureza. Não eram tempos fáceis e cada refeição se transformava numa grande empreitada atrás de alimento. A troca de experiências (isto é, a velocidade de propagação de conhecimentos) entre os diversos indivíduos ou entre grupos distintos era incrivelmente lenta. Uma grande transformação veio mudar esse panorama pré-histórico: a revolução agrícola. As mudanças resultantes desse processo foram profundas, e dentre elas a domesticação de animais teve um significado essencialmente importante: o deslocamento humano por longas distâncias foi enormemente facilitado. A velocidade de propagação de conhecimentos começava a se acelerar.

Muitos milhares de anos depois, uma nova revolução, iniciada em algumas poderosas nações da época, assolou o mundo: a revolução industrial. O advento das máquinas a vapor e um pouco mais tarde dos trens e em seguida dos automóveis consolidaram o domínio dos homens sobre as máquinas. Um pouco mais tarde, desvendado o eletromagnetismo, a velocidade de propagação de informações atingiu níveis impressionantes, graças, sobretudo, ao telégrafo e ao telefone.

Mais recentemente, o surgimento de computadores pessoais relativamente baratos e de redes de comunicação globais como a Internet colocam a humanidade frente a uma nova onda de transformações. As luzes que se acendem são de uma era em que bits valem mais que átomos e que bens materiais não são mais garantia de poder e riqueza. Hoje, expressões como “tempo real” e “sob demanda” nos dão idéia de quão rápido corre a informação através dos canais de comunicação que envolvem o globo.

Depois da revolução agrícola e da revolução industrial, o homem vive a revolução do conhecimento. Não há atividade humana que resista a esse período de transição; o impacto das redes de computadores, da microeletrônica, da nanotecnologia, das telecomunicações é total, pode ser sentido no trabalho, na educação, no entretenimento, nas artes. O homem, inabalável, segue como parte integrante e atuante neste cenário de singularidade e de intensas mudanças tecnológicas. A sociedade é agora “pós-industrial” e vive-se o que é chamado de “era da informação”.

O microchip marcou -- assim como a máquina a vapor, a eletricidade e a linha de montagem em outros tempos -- um avanço singular no desenvolvimento tecnológico da humanidade. Na nova economia, sai a linha de produção, os carros, o aço, a produção em massa, o marketing de massa e a mídia de massa que distribuíam seus produtos provenientes de grandes indústrias, estúdios e editoras. Entram os websites, rápidos como a luz numa fibra óptica, provendo conteúdo especializado e customizável, milhares deles, a poucos cliques do mouse de distância. É a informação em estado puro, na forma de bits -- intangível, inodoro, incolor, invisível, mas mensurável (não em volts, mas em milhões de dólares!).

O futuro dos microchips

Nos domínios da microeletrônica, nenhuma previsão ficou tão conhecida (e vem perdurando tanto) como a “Lei de Moore”. Em meados da década de 60, Gordon Moore, um dos fundadores da Intel, previu que o poder de processamento dos microchips dobraria a cada 18 meses, enquanto que, ao mesmo tempo, seus custos cairiam pela metade.

O sucesso da “Lei de Moore” deve-se, em parte, às próprias características da microeletrônica -- pelo menos em seu estágio atual. A fabricação de microchips hoje, por mais complexos que venham se tornando, não foge à receita simples do “wafer” (lâmina em forma de disco que se assemelha a uma bolacha redonda) de silício coberto de microcomponentes eletrônicos. Simplesmente ainda não se descobriu maneira melhor de colocar tamanho número de componentes num espaço tão diminuto. Mas o futuro do silício pode ter seus dias contados. Outros materiais com propriedades dos semicondutores, capazes de desempenhar funções de transistores, já estão sendo pesquisados: são polímeros condutores, estruturas cristalinas orgânicas, materiais cerâmicos, entre outros.

Cada um desses materiais oferece uma determinada vantagem em relação ao silício (como maior velocidade, menor consumo de energia, etc.). Essas novas técnicas abrem novas perspectivas para a microeletrônica e para a computação, e podem um dia vir a substituir o atual paradigma -- baseado na tecnologia CMOS VLSI -- que tornou populares as arquiteturas Pentium, da Intel, PowerPC, da Motorola, IBM e Apple, e também Alpha, da Digital. Essas arquiteturas encontram suas raízes nas idéias do matemático John von Neumann, um dos pioneiros no projeto de computadores durante as décadas de 40 e 50. O próprio microprocessador é um exemplo do sucesso da arquitetura digital von Neumman: uma seqüência de operações acessa dados de uma memória central, processa-os e em seguida retorna os resultados.

Outras abordagens para projeto e construção de circuitos capazes de processar informação já estão em desenvolvimento. Uma dessas abordagens é a utilização de sistemas analógicos como as redes neurais -- inspiradas no modo como alguns sistemas biológicos processam informação. Para alguns pesquisadores, sistemas neurais/analógicos representam o futuro da computação.

Independentemente da arquitetura adotada, um passo certo em direção ao futuro é certamente a flexibilidade dos microchips de amanhã. Chips configuráveis, customizáveis, capazes de rodar os principais sistemas operacionais serão características importantes num futuro próximo -- haja vista os recentes investimentos do multimilionário e co-fundador da Microsoft Paul Allen na empresa Transmeta (em que trabalha também Linus Torvalds), dedicada ao desenvolvimento de novos tipos de chips e processadores.

Novos paradigmas computacionais

Mas existem limites para a computação? Até onde vai o sonho humano de computar? É certo que, teoricamente, não existem limites. Tudo depende da tecnologia em que se baseiam os sistemas computacionais. A computação baseada em chips de silício certamente encontrará seus limites. Empecilhos de natureza física e tecnológica tornarão inviável a evolução ad infinitum dos chips de silício.

Nada, porém, parece ser capaz de frear a vontade do homem de construir máquinas cada vez mais "poderosas". Embora os custos e dificuldades tecnológicas tornem proibitivo construir “superchips” para “supercomputadores”, a supercomputação tornou-se realidade de forma engenhosa: utilizando dezenas ou até centenas de chips convencionais e realizando o que ficou conhecido como “processamento paralelo distribuído”. A computação de alto desempenho e o processamento paralelo é que permitem, por exemplo, criar efeitos especiais para o cinema cada vez mais realistas (como os do filme “Titanic”) e simular sistemas cada vez mais complexos (como reações químicas nucleares ou até o “Big Bang”).

Leia também - Visão Noturna

Além disso, formas revolucionárias de computação vem sendo pesquisadas, como a computação quântica e a computação biológica com DNA. Embora experimentais, estas pesquisas vêm mostrando-se bastante promissoras. Talvez possam substituir os chips de silício na próxima década. No caso da computação quântica, os cientistas esperam conseguir manipular átomos, moléculas e suas partículas subatômicas para processar informações. A eletrônica molecular (“moletronics”, como está ficando conhecida) promete construir superchips do tamanho de grãos de areia cem bilhões de vezes mais rápidos que um processador Pentium.

Com a miniaturização cada vez mais acelerada dos microchips, será possível embutir esses dispositivos em todo tipo de objeto -- e também no corpo humano! Em agosto de 1998, o professor Kevin Warwick, da Universidade de Reading, na Inglaterra, implantou cirurgicamente um microchip em seu braço esquerdo. Ondas eletromagnéticas geravam corrente elétrica em uma pequena bobina acoplada ao microchip. Warwick podia então andar pelo seu laboratório e interagir com as coisas ao seu redor (portas eram abertas. O próximo passo de Warwick é implantar um novo chip, mais sofisticado, que seja capaz de “monitorar” seus impulsos nervosos. O pesquisador quer identificar os impulsos nervosos correspondentes às diversas sensações e sentimentos humanos. Em seguida, quer gerar esses impulsos em um computador e introduzi-los em seu sistema nervoso por meio do microchip.

Fonte:http://www.discoverybrasil.com/

http://www.lsi.usp.br/~chip/index.html