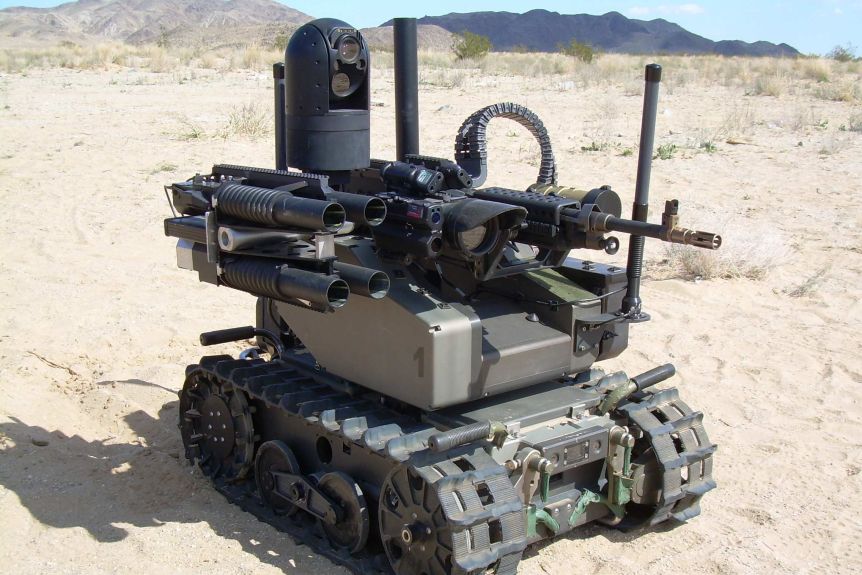

15/10/2020, por Frank Pasquale - Máquinas autônomas capazes de força letal são cada vez mais prevalentes na guerra moderna, apesar de inúmeras preocupações éticas. Existe algo que possamos fazer para deter o avanço dos robôs assassinos? O vídeo é nítido. Dois homens ameaçadores estão ao lado de uma van branca em um campo, segurando controles remotos. Eles abrem as portas traseiras da van e o som de zumbidos de drones quadricópteros crescendos. Eles ligam um interruptor e os drones saem em enxame como morcegos de uma caverna. Em alguns segundos, cortamos para uma sala de aula da faculdade. Os robôs assassinos invadem as janelas e aberturas.

15/10/2020, por Frank Pasquale - Máquinas autônomas capazes de força letal são cada vez mais prevalentes na guerra moderna, apesar de inúmeras preocupações éticas. Existe algo que possamos fazer para deter o avanço dos robôs assassinos? O vídeo é nítido. Dois homens ameaçadores estão ao lado de uma van branca em um campo, segurando controles remotos. Eles abrem as portas traseiras da van e o som de zumbidos de drones quadricópteros crescendos. Eles ligam um interruptor e os drones saem em enxame como morcegos de uma caverna. Em alguns segundos, cortamos para uma sala de aula da faculdade. Os robôs assassinos invadem as janelas e aberturas.

Os alunos gritam de terror, presos lá dentro, enquanto os drones atacam com força mortal. A lição que o filme Slaughterbots está tentando transmitir é clara: pequenos robôs assassinos estão aqui ou a um pequeno avanço tecnológico de distância. Terroristas podem facilmente implantá-los. E as defesas existentes são fracas ou inexistentes.

Alguns especialistas militares argumentaram que Slaughterbots - que foi feito pelo Instituto Future of Life, uma organização que pesquisa ameaças existenciais à humanidade - sensacionalizou um problema sério, alimentando o medo onde uma reflexão calma era necessária. Mas quando se trata do futuro da guerra, a linha entre a ficção científica e os fatos industriais costuma ser confusa. A Força Aérea dos Estados Unidos previu um futuro em que “as equipes do Swat enviarão insetos mecânicos equipados com câmeras de vídeo para se infiltrar dentro de um prédio durante um confronto com reféns”. Um “microssistemas colaborativos” já lançou Octoroach, um “robô extremamente pequeno com uma câmera e um transmissor de rádio que pode cobrir até 100 metros no solo”. É apenas uma das muitas armas “biomiméticas”, ou imitações da natureza, que estão no horizonte.

Leia também - PlayStation VR

Quem sabe quantas outras criaturas nocivas são agora modelos para teóricos militares de vanguarda. Um romance recente de PW Singer e August Cole, ambientado em um futuro próximo no qual os EUA estão em guerra com a China e a Rússia, apresentou uma visão caleidoscópica de drones autônomos, lasers e satélites sequestrados. O livro não pode ser descartado como uma fantasia técnico-militar: inclui centenas de notas de rodapé que documentam o desenvolvimento de cada peça de hardware e software que descreve.

Os avanços na modelagem de máquinas de matar robóticas não são menos perturbadores. Uma história de ficção científica russa dos anos 60, Crabs on the Island, descreve uma espécie de Hunger Games for AIs, em que os robôs lutam entre si por recursos. Os perdedores seriam descartados e os vencedores apareceriam, até que alguns evoluíram para se tornarem as melhores máquinas de matar. Quando um importante cientista da computação mencionou um cenário semelhante ao da Agência de Projetos de Pesquisa Avançada de Defesa (Darpa) dos Estados Unidos, chamando-o de "Robô Jurassic Park", um líder disse que era "viável". Não é preciso muita reflexão para perceber que tal experimento tem o potencial de ficar totalmente fora de controle. A despesa é o principal obstáculo para uma grande potência fazer experiências com tais máquinas potencialmente destrutivas. A modelagem de software pode eliminar até mesmo essa barreira, permitindo que simulações virtuais testadas em batalha inspirem futuros investimentos militares.

No passado, os estados-nação se uniram para proibir novas armas particularmente horríveis ou aterrorizantes. Em meados do século 20, as convenções internacionais baniram as armas biológicas e químicas. A comunidade das nações também proibiu o uso da tecnologia de laser cegante. Uma rede robusta de ONGs exortou com sucesso a ONU a convocar os estados membros a concordar com uma proibição semelhante de robôs assassinos e outras armas que podem agir por conta própria, sem controle humano direto, para destruir um alvo (também conhecido como sistemas de armas autônomas letais , ou Leis). E embora tenha havido debate sobre a definição de tal tecnologia, todos nós podemos imaginar alguns tipos de armas particularmente terríveis que todos os estados deveriam concordar em nunca fabricar ou implantar. Um drone que gradualmente esquentasse soldados inimigos até a morte violaria as convenções internacionais contra a tortura; armas sônicas projetadas para destruir a audição ou o equilíbrio de um inimigo devem merecer tratamento semelhante. Um país que projetou e usou tais armas deve ser exilado da comunidade internacional.

Em resumo, provavelmente podemos concordar que o ostracismo - e punições mais severas - também é merecido para os designers e usuários de robôs assassinos. A própria ideia de uma máquina solta para o abate é assustadora. E, no entanto, alguns dos maiores militares do mundo parecem estar se arrastando para o desenvolvimento de tais armas, seguindo uma lógica de dissuasão: eles temem ser esmagados pela IA dos rivais se não puderem desencadear uma força igualmente potente. A chave para resolver uma corrida armamentista tão intratável pode estar menos em tratados globais do que em um repensar preventivo de para que a IA marcial pode ser usada. À medida que a "guerra volta para casa", o desdobramento de força militar em países como os Estados Unidos e a China é um forte aviso aos seus cidadãos: quaisquer tecnologias de controle e destruição que você permitir que seu governo compre para uso no exterior agora podem ser usadas contra você no futuro.

Robôs assassinos são tão horríveis quanto armas biológicas? Não necessariamente, argumentam alguns teóricos militares estabelecidos e cientistas da computação. De acordo com Michael Schmitt, do US Naval War College, robôs militares poderiam policiar os céus para garantir que uma matança como a matança de curdos e árabes por Saddam Hussein não acontecesse novamente. Ronald Arkin, do Instituto de Tecnologia da Geórgia, acredita que os sistemas de armas autônomos podem "reduzir a desumanidade do homem ao homem por meio da tecnologia", já que um robô não estará sujeito a acessos humanos demais de raiva, sadismo ou crueldade. Ele propôs tirar os humanos do ciclo de decisões sobre alvos, enquanto codifica as restrições éticas em robôs. Arkin também desenvolveu uma classificação de alvos para proteger locais como hospitais e escolas.

Em teoria, uma preferência por violência controlada por máquina em vez de violência humana imprevisível pode parecer razoável. Os massacres que acontecem durante a guerra muitas vezes parecem estar enraizados em emoções irracionais. No entanto, muitas vezes reservamos nossa condenação mais profunda não para a violência praticada no calor da paixão, mas para o assassino premeditado que friamente planejou seu ataque. A história da guerra oferece muitos exemplos de massacres planejados com mais cuidado. E certamente qualquer sistema de armas robóticas provavelmente será projetado com algum tipo de recurso de anulação, que seria controlado por operadores humanos, sujeito a todas as paixões humanas normais e irracionalidade.

Qualquer tentativa de codificar a lei e a ética em robôs assassinos levanta enormes dificuldades práticas. O professor de ciência da computação Noel Sharkey argumentou que é impossível programar um guerreiro robô com reações à infinita gama de situações que podem surgir no calor de um conflito. Como um carro autônomo desamparado pela neve interferindo em seus sensores, um sistema de armas autônomo na névoa da guerra é perigoso.

Leia também - Cientistas criam porcos fosforescentes verdes

A maioria dos soldados testemunharia que a experiência cotidiana da guerra são longos períodos de tédio pontuados por feitiços de desordem repentinos e aterrorizantes. Padronizar relatos de tais incidentes, a fim de orientar armas robóticas, pode ser impossível. O aprendizado de máquina funcionou melhor onde há um grande conjunto de dados com exemplos claramente compreendidos de bom e mau, certo e errado. Por exemplo, as empresas de cartão de crédito aprimoraram os mecanismos de detecção de fraude com análises constantes de centenas de milhões de transações, onde falsos negativos e falsos positivos são facilmente rotulados com quase 100% de precisão. Seria possível "datafy" as experiências de soldados no Iraque, decidindo se atirar em inimigos ambíguos? Mesmo se fosse, qual seria a relevância desse conjunto de dados para ocupações, digamos, do Sudão ou do Iêmen (duas das muitas nações com algum tipo de presença militar dos EUA)?

Dadas essas dificuldades, é difícil evitar a conclusão de que a idéia de máquinas de matar robóticas éticas é irreal e muito provável de sustentar fantasias perigosas de guerras de botões e massacres sem culpa. O Direito Internacional Humanitário, que governa os conflitos armados, apresenta ainda mais desafios para os desenvolvedores de armas autônomas. Um princípio ético fundamental da guerra tem sido o da discriminação: exigir que os atacantes façam a distinção entre combatentes e civis. Mas a guerra de guerrilha ou insurgente se tornou cada vez mais comum nas últimas décadas, e os combatentes em tais situações raramente usam uniformes, tornando mais difícil distingui-los dos civis. Dadas as dificuldades que os soldados humanos enfrentam a esse respeito, é fácil ver o risco ainda maior representado pelos sistemas de armas robóticas.

Os defensores de tais armas insistem que os poderes de discriminação das máquinas estão apenas melhorando. Mesmo que seja assim, é um grande salto lógico presumir que os comandantes usarão esses avanços tecnológicos para desenvolver princípios justos de discriminação no barulho e na confusão da guerra. Como escreveu o pensador francês Grégoire Chamayou, a categoria de “combatente” (um alvo legítimo) já tendeu a “se diluir de forma a se estender a qualquer forma de filiação, colaboração ou presumida simpatia por algum militante organização".

O princípio de distinguir entre combatentes e civis é apenas uma das muitas leis internacionais que regem a guerra. Há também a regra de que as operações militares devem ser “proporcionais” - um equilíbrio deve ser alcançado entre o dano potencial a civis e a vantagem militar que pode resultar da ação. A Força Aérea dos Estados Unidos descreveu a questão da proporcionalidade como “uma determinação inerentemente subjetiva que será resolvida caso a caso”. Não importa o quão bem a tecnologia monitora, detecta e neutraliza ameaças, não há evidências de que ela possa se envolver no tipo de raciocínio sutil e flexível essencial para a aplicação de leis ou normas até mesmo ligeiramente ambíguas.

Mesmo se assumíssemos que os avanços tecnológicos poderiam reduzir o uso da força letal na guerra, isso sempre seria uma coisa boa? Ao examinar a crescente influência dos princípios dos direitos humanos nos conflitos, o historiador Samuel Moyn observa um paradoxo: a guerra tornou-se ao mesmo tempo “mais humana e mais difícil de acabar”. Para os invasores, os robôs poupam os políticos da preocupação de baixas, alimentando a oposição em casa. Um punho de ferro na luva de veludo de tecnologia avançada, os drones podem exercer vigilância apenas o suficiente para pacificar os ocupados, evitando o tipo de derramamento de sangue devastador que provocaria uma revolução ou intervenção internacional.

Nessa visão robotizada de “dominação humana”, a guerra pareceria cada vez mais com uma ação policial extraterritorial. Os inimigos seriam substituídos por suspeitos sujeitos a detenção mecanizada em vez de uso de força letal. Por mais salvador que possa ser, sugere Moyn, o enorme diferencial de poder no cerne das ocupações tecnologizadas não é um fundamento adequado para uma ordem internacional legítima.

Chamayou também é cético. Em seu livro perspicaz Drone Theory, ele lembra os leitores da matança de 10.000 sudaneses em 1898 por uma força anglo-egípcia armada com metralhadoras, que sofreu apenas 48 baixas. Chamayou classifica o drone como “a arma da violência pós-colonial amnésica”. Ele também lança dúvidas sobre se os avanços na robótica realmente resultariam no tipo de precisão que os fãs de robôs assassinos prometem. Os civis são rotineiramente mortos por drones militares pilotados por humanos. Remover essa possibilidade pode envolver um futuro igualmente sombrio no qual os sistemas de computação conduzem uma vigilância tão intensa sobre as populações em questão que podem avaliar a ameaça representada por cada pessoa dentro deles (e liquidá-los ou poupá-los de acordo).

Os defensores dos drones dizem que a arma é a chave para uma guerra mais discriminadora e humana. Mas para Chamayou, “ao descartar a possibilidade de combate, o drone destrói a própria possibilidade de qualquer diferenciação clara entre combatentes e não combatentes”. A afirmação de Chamayou pode parecer uma hipérbole, mas considere a situação no Iêmen ou no interior do Paquistão: existe realmente alguma resistência séria que os "militantes" possam sustentar contra uma corrente de centenas ou milhares de veículos aéreos não tripulados patrulhando seus céus? Esse ambiente controlado equivale a uma perturbadora fusão de guerra e policiamento, sem as restrições e salvaguardas que foram estabelecidas para, pelo menos, tentar tornar esses campos responsáveis.

Como os líderes globais devem responder à perspectiva dessas novas tecnologias de armas perigosas? Uma opção é tentar nos unir para banir completamente certos métodos de matar. Para entender se esses acordos internacionais de controle de armas poderiam funcionar ou não, vale a pena olhar para o passado. A mina terrestre antipessoal, projetada para matar ou mutilar qualquer um que pisasse ou estivesse perto dela, foi uma das primeiras armas automatizadas. Ele aterrorizou os combatentes na Primeira Guerra Mundial. Baratas e fáceis de distribuir, as minas continuaram a ser usadas em conflitos menores em todo o mundo. Em 1994, os soldados colocaram 100 milhões de minas terrestres em 62 países.

As minas continuaram a devastar e intimidar as populações por anos após o fim das hostilidades. As vítimas de minas geralmente perdiam pelo menos uma perna, às vezes duas, e sofriam lacerações colaterais, infecções e traumas. Em 1994, 1 em 236 cambojanos havia perdido pelo menos um membro com a detonação de minas.

Em meados dos anos 90, havia um consenso internacional crescente de que as minas terrestres deveriam ser proibidas. A Campanha Internacional para Banir as Minas Terrestres pressionou governos em todo o mundo para condená-los. A mina terrestre não é tão mortal quanto muitas outras armas, mas ao contrário de outras aplicações de força, ela pode mutilar e matar não-combatentes muito depois do fim da batalha. Em 1997, quando a campanha para banir as minas terrestres ganhou o Prêmio Nobel da Paz, dezenas de países assinaram um tratado internacional, com força obrigatória, prometendo não fabricar, armazenar ou implantar tais minas.

Os Estados Unidos objetaram e até hoje não assinaram a convenção de armas anti-minas terrestres. No momento das negociações, os negociadores dos Estados Unidos e do Reino Unido insistiram que a solução real para o problema das minas terrestres era garantir que as futuras minas fossem desligadas automaticamente após um período fixo de tempo ou que tivessem alguma capacidade de controle remoto. Isso significaria que um dispositivo poderia ser desligado remotamente assim que as hostilidades cessassem. É claro que ele também pode ser ligado novamente.

O solucionismo tecnológico dos EUA encontrou poucos defensores. Em 1998, dezenas de países assinaram o tratado de proibição de minas. Mais países aderiram a cada ano de 1998 a 2010, incluindo grandes potências como a China. Enquanto o governo Obama deu alguns passos importantes para limitar as minas, o secretário de defesa de Trump os reverteu. Essa reviravolta é apenas uma faceta de um nacionalismo belicoso que provavelmente acelerará a automação da guerra.

Em vez de proibir robôs assassinos, o establishment militar dos EUA prefere regulamentação. As preocupações com o mau funcionamento, falhas ou outras consequências não intencionais do armamento automatizado deram origem a um discurso medido de reforma em torno da robótica militar. Por exemplo, o PW Singer da New America Foundation permitiria que um robô fizesse "uso autônomo apenas de armas não letais". Portanto, um drone autônomo poderia patrulhar um deserto e, digamos, atordoar um combatente ou envolvê-lo em uma rede, mas a “decisão de matar” seria deixada apenas para os humanos. Sob esta regra, mesmo que o combatente tentasse destruir o drone, o drone não poderia destruí-lo.

Leia também - Já imaginou acampar com uma barraca que produz energia solar (e ainda tem sinal de internet)?

Essas regras ajudariam na transição da guerra para a manutenção da paz e, finalmente, para uma forma de policiamento. O tempo entre as decisões de captura e morte pode permitir o devido processo necessário para avaliar a culpa e definir uma punição. Singer também enfatiza a importância da responsabilização, argumentando que “se um programador fizer explodir uma aldeia inteira por engano, ele deve ser processado criminalmente”.

Enquanto alguns teóricos militares querem codificar robôs com ética algorítmica, Singer sabiamente se baseia em nossa experiência de séculos em regular pessoas. Para garantir a responsabilidade pela implantação de “algoritmos de guerra”, os militares precisariam garantir que robôs e agentes algorítmicos sejam rastreáveis e identificados com seus criadores. No contexto doméstico, os estudiosos propuseram uma "placa de licença para drones", para vincular qualquer ação imprudente ou negligente ao proprietário ou controlador do drone. Faz sentido que uma regra semelhante - algo como “Um robô deve sempre indicar a identidade de seu criador, controlador ou proprietário” - deva servir como uma regra fundamental de guerra, e sua violação punível com sanções severas.

No entanto, quão provável é, realmente, que programadores de robôs assassinos sejam realmente punidos? Em 2015, os militares dos EUA bombardearam um hospital no Afeganistão, matando 22 pessoas. No momento em que o bombardeio estava ocorrendo, a equipe do hospital ligou freneticamente para seus contatos nas forças armadas dos EUA para implorar que parasse. Os seres humanos têm sido diretamente responsáveis por ataques de drones em hospitais, escolas, festas de casamento e outros alvos inadequados, sem consequências proporcionais. A “névoa da guerra” desculpa todo tipo de negligência. Não parece provável que os sistemas jurídicos domésticos ou internacionais imponham mais responsabilidade aos programadores que causam carnificina semelhante.

O armamento sempre foi um grande negócio, e uma corrida armamentista de IA promete lucros para os conhecedores de tecnologia e politicamente bem conectados. O aconselhamento contra corridas armamentistas pode parecer totalmente irreal. Afinal, as nações estão despejando recursos maciços em aplicações militares de IA, e muitos cidadãos não sabem ou não se importam. No entanto, essa atitude quiescente pode mudar com o tempo, à medida que o uso doméstico de vigilância de IA aumenta, e essa tecnologia é cada vez mais identificada com aparatos obscuros de controle, em vez de poderes locais democraticamente responsáveis.

A IA militar e de vigilância não é usada apenas, ou mesmo principalmente, em inimigos estrangeiros. Ele foi reaproveitado para identificar e lutar contra os inimigos internos. Embora nada parecido com os ataques de 11 de setembro tenha surgido ao longo de quase duas décadas nos Estados Unidos, as forças de segurança interna silenciosamente viraram ferramentas antiterror contra criminosos, fraudes de seguros e até mesmo manifestantes. Na China, o governo exagerou a ameaça de "terrorismo muçulmano" para reunir uma porcentagem considerável de seus uigures em campos de reeducação e intimidar outros com inspeções telefônicas constantes e perfis de risco. Ninguém deveria se surpreender se algum equipamento chinês alimentasse um aparelho de inteligência doméstico dos EUA, enquanto grandes empresas de tecnologia dos EUA são cooptadas pelo governo chinês para projetos de vigilância paralelos.

Fonte: https://www.theguardian.com/