01/03/2022 - A equipe de pesquisa ATAP da empresa está usando o radar para ajudar os computadores a responder aos seus movimentos, como desligar uma TV se perceber que você cochilou. E SE SEU computador decidisse não emitir um jingle de notificação porque notou que você não estava sentado em sua mesa? E se a sua TV o visse sair do sofá para atender a porta da frente e pausasse o Netflix automaticamente e retomasse a reprodução quando você se sentasse?

01/03/2022 - A equipe de pesquisa ATAP da empresa está usando o radar para ajudar os computadores a responder aos seus movimentos, como desligar uma TV se perceber que você cochilou. E SE SEU computador decidisse não emitir um jingle de notificação porque notou que você não estava sentado em sua mesa? E se a sua TV o visse sair do sofá para atender a porta da frente e pausasse o Netflix automaticamente e retomasse a reprodução quando você se sentasse?

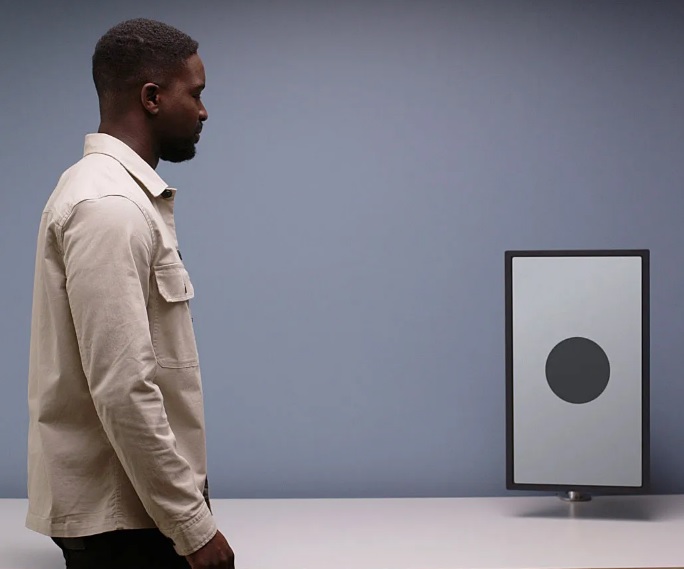

E se nossos computadores pegassem mais dicas sociais de nossos movimentos e aprendessem a ser companheiros mais atenciosos? Parece futurista e talvez mais do que um pouco invasivo – um computador observando cada movimento seu? Mas parece menos assustador quando você aprende que essas tecnologias não precisam depender de uma câmera para ver onde você está e o que está fazendo. Em vez disso, eles usam radar. A divisão de Produtos e Tecnologia Avançada do Google – mais conhecida como ATAP, o departamento por trás de projetos excêntricos, como uma jaqueta jeans sensível ao toque – passou o ano passado explorando como os computadores podem usar o radar para entender nossas necessidades ou intenções e reagir adequadamente.

Esta não é a primeira vez que vemos o Google usar radar para fornecer a seus gadgets consciência espacial. Em 2015, o Google lançou o Soli, um sensor que pode usar as ondas eletromagnéticas do radar para captar gestos e movimentos precisos. Foi visto pela primeira vez na capacidade do Google Pixel 4 de detectar gestos simples com as mãos para que o usuário pudesse adiar alarmes ou pausar a música sem precisar tocar fisicamente no smartphone. Mais recentemente, sensores de radar foram incorporados ao monitor inteligente Nest Hub de segunda geração para detectar os padrões de movimento e respiração da pessoa que dorme ao lado dele. O dispositivo foi então capaz de rastrear o sono da pessoa sem exigir que ela usasse um smartwatch.

Leia também - Cientistas desenvolveram vasos sanguíneos artificiais de células do CADAVER

O mesmo sensor Soli está sendo usado nesta nova rodada de pesquisa, mas em vez de usar a entrada do sensor para controlar diretamente um computador, a ATAP está usando os dados do sensor para permitir que os computadores reconheçam nossos movimentos diários e façam novos tipos de escolhas.

“Acreditamos que à medida que a tecnologia se torna mais presente em nossa vida, é justo começarmos a pedir à própria tecnologia que nos dê mais algumas dicas”, diz Leonardo Giusti, chefe de design da ATAP. Da mesma forma que sua mãe pode lembrá-lo de pegar um guarda-chuva antes de sair pela porta, talvez seu termostato possa transmitir a mesma mensagem quando você passar e olhar para ele - ou sua TV pode diminuir o volume se detectar que você adormeceu no sofá.

Pesquisa de radar

Giusti diz que grande parte da pesquisa é baseada em proxêmica, o estudo de como as pessoas usam o espaço ao seu redor para mediar interações sociais. À medida que você se aproxima de outra pessoa, espera um maior envolvimento e intimidade. A equipe da ATAP usou essa e outras dicas sociais para estabelecer que pessoas e dispositivos têm seus próprios conceitos de espaço pessoal.

O radar pode detectar você se aproximando de um computador e entrando em seu espaço pessoal. Isso pode significar que o computador pode optar por executar determinadas ações, como inicializar a tela sem exigir que você pressione um botão. Esse tipo de interação já existe nos atuais monitores inteligentes do Google Nest, embora, em vez de radar, o Google empregue ondas sonoras ultrassônicas para medir a distância de uma pessoa do dispositivo. Quando um Nest Hub percebe que você está se aproximando, ele destaca os lembretes atuais, eventos da agenda ou outras notificações importantes.

A proximidade por si só não é suficiente. E se você acabasse passando pela máquina e olhando em uma direção diferente? Para resolver isso, o Soli pode capturar maiores sutilezas em movimentos e gestos, como orientação do corpo, o caminho que você pode estar tomando e a direção que sua cabeça está voltada - auxiliado por algoritmos de aprendizado de máquina que refinam ainda mais os dados. Todas essas ricas informações de radar ajudam a adivinhar melhor se você está realmente prestes a iniciar uma interação com o dispositivo e qual pode ser o tipo de envolvimento.

Essa detecção aprimorada veio da equipe realizando uma série de tarefas coreografadas em suas próprias salas de estar (ficaram em casa durante a pandemia) com câmeras suspensas rastreando seus movimentos e detecção de radar em tempo real.

”Conseguimos nos mover de diferentes maneiras, realizamos diferentes variações desse movimento e, então – dado que este era um sistema em tempo real com o qual estávamos trabalhando – fomos capazes de improvisar e construir nossas descobertas em tempo real. tempo", diz Lauren Bedal, designer de interação sênior da ATAP.

Bedal, que tem formação em dança, diz que o processo é bastante semelhante ao modo como os coreógrafos pegam uma ideia básica de movimento – conhecida como motivo de movimento – e exploram variações dela, como a forma como o dançarino muda seu peso ou muda sua posição corporal e orientação. A partir desses estudos, a equipe formalizou um conjunto de movimentos, todos inspirados na comunicação não verbal e na forma como naturalmente interagimos com os dispositivos: aproximar ou sair, passar, virar ou afastar e olhar.

Bedal listou alguns exemplos de computadores reagindo a esses movimentos. Se um dispositivo perceber que você está se aproximando, ele pode abrir os controles de toque; aproxime-se de um dispositivo e ele poderá destacar os e-mails recebidos; sair de uma sala, e a TV pode marcar onde você saiu e retomar a partir dessa posição quando você voltar. Se um dispositivo determinar que você está apenas passando, ele não o incomodará com notificações de baixa prioridade. Se você estiver na cozinha seguindo uma receita em vídeo, o dispositivo pode pausar quando você se afastar para pegar os ingredientes e retomar à medida que você recua e expressa essa intenção de se envolver novamente. E se você olhar para um display inteligente quando estiver em uma chamada telefônica, o dispositivo poderá oferecer a opção de transferir para uma chamada de vídeo para que você possa desligar o telefone.

“Todos esses movimentos começam a sugerir uma maneira futura de interagir com computadores que parecem muito invisíveis, aproveitando as maneiras naturais que nos movemos, e a ideia é que os computadores possam ficar em segundo plano e apenas nos ajudar nos momentos certos. ”, diz Bedal. “Estamos realmente apenas empurrando os limites do que percebemos ser possível para a interação humano-computador.”

Tudo bem, computador

Utilizar o radar para influenciar como os computadores reagem a nós traz desafios. Por exemplo, enquanto o radar pode detectar várias pessoas em uma sala, se os assuntos estiverem muito próximos, o sensor apenas vê o bando de pessoas como uma bolha amorfa, o que confunde a tomada de decisões. Também há muito mais a ser feito, e é por isso que Bedal destacou (algumas vezes) que esse trabalho está em fase de pesquisa - então não, não espere isso em sua tela inteligente de última geração ainda.

Há boas razões para pensar que o radar também pode ajudar a aprender suas rotinas ao longo do tempo. Esta é uma área que Giusti da ATAP diz estar no roteiro de pesquisa, com oportunidades como sugerir hábitos saudáveis relacionados aos seus próprios objetivos. Imagino minha tela inteligente se transformando em um sinal gigante de pare quando percebe que estou indo para o armário de lanches à meia-noite.

Há também um equilíbrio que esses dispositivos precisarão atingir quando se trata de executar um conjunto de ações que você acha que deseja. Por exemplo, e se eu quiser a TV ligada enquanto estiver na cozinha cozinhando? O radar não detectava ninguém assistindo à TV e o pausava em vez de deixá-lo ligado. “À medida que começamos a pesquisar alguns desses paradigmas de interação que parecem muito invisíveis, contínuos e fluidos, é preciso haver um equilíbrio certo entre o controle do usuário e a automação”, diz Bedal. “Deve ser fácil, mas devemos considerar o número de controles ou configurações que o usuário pode querer do seu lado.”

Leia também - Como são feitas as vacinas?

A equipe da ATAP optou por usar o radar porque é um dos métodos mais amigáveis à privacidade de coletar dados espaciais ricos. (Ele também tem latência muito baixa, funciona no escuro e fatores externos, como som ou temperatura, não o afetam.) Ao contrário de uma câmera, o radar não captura e armazena imagens distinguíveis de seu corpo, rosto ou outros meios de identificação. “É mais como um sensor de movimento avançado”, diz Giusti. Soli tem um alcance detectável de cerca de 9 pés - menos do que a maioria das câmeras - mas vários dispositivos em sua casa com o sensor Soli podem cobrir efetivamente seu espaço e criar uma rede mesh eficaz para rastrear seu paradeiro em uma casa. (Vale a pena notar que os dados do sensor Soli no Google Nest Hub atual são processados localmente e os dados brutos nunca são enviados para a nuvem.)

Chris Harrison, pesquisador que estuda interação humano-computador na Carnegie Mellon University e diretor do Future Interfaces Group, diz que os consumidores terão que decidir se querem fazer essa troca de privacidade – afinal, o Google é “o líder mundial em monetizar seus dados ”—mas ele ainda acha que a abordagem sem câmeras do Google é uma perspectiva que prioriza o usuário e a privacidade. “Não existe invasão de privacidade e não invasão de privacidade”, diz Harrison. “Tudo está em um espectro.”

Como os dispositivos são inevitavelmente habilitados com sensores – como Soli – para coletar mais dados, eles são mais capazes de nos entender. Em última análise, Harrison espera ver os tipos de interações humano-computador aprimoradas que a ATAP prevê em todas as facetas da tecnologia.

“Os seres humanos são programados para realmente entender o comportamento humano e, quando os computadores o quebram, isso leva a esse tipo de situação extra frustrante”, diz Harrison. “Trazer pessoas como cientistas sociais e cientistas comportamentais para o campo da computação torna essas experiências muito mais agradáveis e muito mais humanísticas.”

A pesquisa do Google ATAP faz parte de uma nova série chamada In the Lab With Google ATAP, que estreará novos episódios nos próximos meses em seu canal no YouTube. Os episódios futuros vão dar uma olhada em outros projetos na divisão de pesquisa do Google.

Fonte: https://www.wired.com/