14/02/2021 - Identificar vídeos adulterados é fundamental. Mas assumir que tudo é falso permite que os autocratas duvidem de vídeos reais de sua violência. UM VÍDEO VIRAL mostra uma jovem dando uma aula de ginástica em uma rotatória na capital birmanesa, Nyapyidaw. Atrás dela, um comboio militar se aproxima de um posto de controle para realizar prisões no prédio do Parlamento. Ela inadvertidamente filmou um golpe? Ela continua dançando.

14/02/2021 - Identificar vídeos adulterados é fundamental. Mas assumir que tudo é falso permite que os autocratas duvidem de vídeos reais de sua violência. UM VÍDEO VIRAL mostra uma jovem dando uma aula de ginástica em uma rotatória na capital birmanesa, Nyapyidaw. Atrás dela, um comboio militar se aproxima de um posto de controle para realizar prisões no prédio do Parlamento. Ela inadvertidamente filmou um golpe? Ela continua dançando.

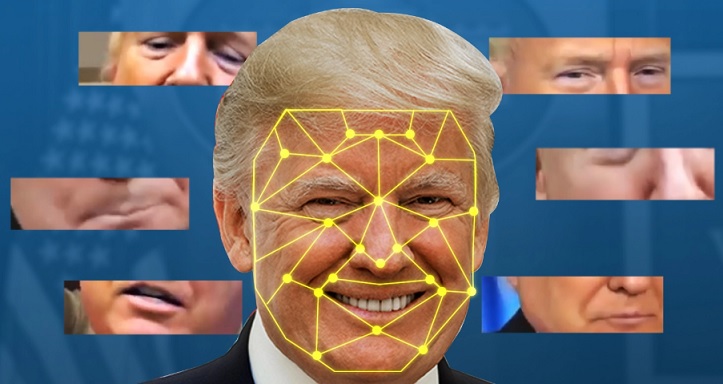

O vídeo mais tarde se tornou um meme viral, mas nos primeiros dias, detetives amadores online debateram se ele era exibido em tela verde ou de outra forma manipulado, muitas vezes usando o jargão de verificação e análise forense de imagens. Para muitos espectadores online, o vídeo captura o absurdo de 2021. No entanto, as alegações de manipulação audiovisual estão cada vez mais sendo usadas para fazer as pessoas se perguntarem se o que é real é falso. Na Witness, além de nosso trabalho contínuo para ajudar as pessoas a filmar a realidade das violações dos direitos humanos, lideramos um esforço global para nos prepararmos melhor para a manipulação audiovisual cada vez mais sofisticada, incluindo os chamados deepfakes. Essas tecnologias fornecem ferramentas para fazer com que alguém pareça dizer ou fazer algo que nunca fez, para criar um evento ou pessoa que nunca existiu ou para editar um vídeo com mais facilidade.

O hype fica aquém, no entanto. A ameaça política e eleitoral de deepfakes reais se presta bem às manchetes, mas a realidade é mais matizada. Os reais motivos de preocupação ficaram claros por meio de reuniões de especialistas que Witness conduziu no Brasil, na África do Sul e na Malásia, bem como nos Estados Unidos e na Europa, com pessoas que passaram por ataques à sua reputação e suas evidências, e profissionais como jornalistas e verificadores de fatos acusados de lutar contra mentiras. Eles destacaram os danos atuais de imagens sexuais não consensuais manipuladas visando mulheres comuns, jornalistas e políticos. Este é um problema real, existente e generalizado, e relatórios recentes confirmaram sua escala crescente.

Seu depoimento também apontou como as alegações de falsificação profunda e manipulação de vídeo estavam sendo cada vez mais usadas para o que os professores de direito Danielle Citron e Bobby Chesney chamam de "dividendo do mentiroso", a capacidade dos poderosos de alegar negação plausível em filmagens incriminatórias. Declarações como "É uma falsificação profunda" ou "Foi manipulado" costumam ser usadas para denegrir um vídeo que vazou de uma situação comprometedora ou para atacar uma das poucas fontes de poder civil em regimes autoritários: a credibilidade de imagens de smartphone da violência estatal. Isso se baseia em histórias de engano patrocinado pelo Estado. Em Mianmar, o exército e as autoridades têm repetidamente compartilhado imagens falsas e questionado a veracidade e integridade das evidências reais de violações dos direitos humanos.

Leia também - O que é o DDT?

Em nossas discussões, jornalistas e defensores dos direitos humanos, incluindo os de Mianmar, descreveram temer o peso de ter que provar implacavelmente o que é real e o que é falso. Eles temiam que seu trabalho não se tornasse apenas desmascarando rumores, mas tendo que provar que algo é autêntico. Audiências céticas e facções públicas questionam as evidências para reforçar e proteger sua visão de mundo e para justificar ações e raciocínio partidário. Nos Estados Unidos, por exemplo, conspiradores e apoiadores de direita rejeitaram o discurso de concessão embaraçoso do ex-presidente Donald Trump após o ataque ao Capitólio, alegando que "é uma mentira profunda"

Não há soluções fáceis. Devemos apoiar habilidades forenses e de verificação audiovisual mais fortes na comunidade e líderes profissionais em todo o mundo que possam ajudar seu público e membros da comunidade. Podemos promover a acessibilidade generalizada de ferramentas de plataforma para tornar mais fácil ver e desafiar os vídeos "superficiais" perenes mal contextualizados ou editados que simplesmente interpretam mal um vídeo ou fazem uma edição básica, bem como deepfakes mais sofisticados. A "infraestrutura de autenticidade" responsável que torna mais fácil rastrear se e como uma imagem foi manipulada e por quem, para aqueles que querem "mostrar seu trabalho", pode ajudar se desenvolvida desde o início com a consciência de como também poderia ser abusado.

Devemos também reconhecer francamente que ferramentas de promoção e habilidades de verificação podem de fato perpetuar uma abordagem conspiratória de “descrença por padrão” na mídia que, de fato, está no cerne do problema com tantos vídeos que mostram a realidade. Qualquer abordagem para fornecer melhores habilidades e infraestrutura deve reconhecer que o raciocínio conspiratório está a um passo da dúvida construtiva. Abordagens de alfabetização midiática e ferramentas forenses de mídia que enviam as pessoas para a toca do coelho em vez de promover o julgamento de bom senso podem ser parte do problema. Nem todos precisamos ser investigadores instantâneos de código aberto. Primeiro, devemos aplicar estruturas simples como a metodologia SIFT: Parar, Investigar a fonte, Encontrar uma cobertura confiável e Rastrear o contexto original.

Neste caso, infelizmente, o instrutor de exercícios estava dançando um hino anti-autoritário enquanto os militares assumiam em tempo real ao fundo. Graças a Deus, por causa desse vídeo, mais pessoas sabem que esse golpe está acontecendo em Mianmar. Não desvie o olhar. Está piorando agora, e os vídeos reais são importantes.

Fonte: https://www.wired.com/